| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- environment value

- 격리 시스템

- assosiated type

- task 취소

- 순환참조

- SwiftUI

- 작업 취소

- Swift

- async/await

- REDRAW

- git 명령어

- Swift Concurrency

- Access Control

- MVVM

- NavigationLink

- 스레드 점유권

- actor

- StateObject

- navigationview

- environment object

- unowned

- 동시성 프로그래밍

- swfitui

- 앱실행

- restful api

- weak

- ObservedObject

- Git

- MainActor

- rest api

- Today

- Total

Develup

[GCD] Swift 성능 최적화: GCD 고급 활용 기법 (1) 본문

단순히 GCD를 사용하는 것과 성능을 극대화하는 방식으로 GCD를 사용하는 것 사이에는 큰 차이가 있습니다. 많은 개발자들이 GCD의 기본 개념은 알고 있지만, 실제 프로덕션 환경에서 최적의 성능을 위해 어떻게 튜닝해야 하는지는 잘 모르는 경우가 많습니다.

이 글에서는 GCD를 사용할 때 흔히 발생하는 성능 문제를 해결하고, 앱의 반응성과 효율성을 높이기 위한 고급 최적화 기법에 대해 알아보겠습니다. 적절한 큐 선택부터 QoS(Quality of Service) 관리, 불필요한 오버헤드 제거까지, 실제 프로젝트에서 즉시 적용할 수 있는 실용적인, 성능 중심의 접근 방식을 제공합니다.

GCD 큐 선택: 어떤 큐가 최적의 선택일까?

전역 큐 vs 커스텀 큐: 언제 무엇을 사용해야 할까?

GCD를 사용할 때 가장 먼저 직면하는 결정은 전역 큐를 사용할 것인지, 커스텀 큐를 생성할 것인지입니다. 이 선택은 성능에 상당한 영향을 미칠 수 있습니다.

전역 큐(Global Queue) 는 시스템에서 관리하는 공유 리소스입니다. 빠르게 접근할 수 있지만, 모든 앱에서 공유되기 때문에 경합이 발생할 수 있습니다.

let globalQueue = DispatchQueue.global(qos: .userInitiated)

반면 커스텀 큐(Custom Queue) 는 앱에서 독점적으로 사용하는 큐입니다. 생성 비용이 있지만, 더 세밀한 제어가 가능합니다.

let customQueue = DispatchQueue(label: "com.myapp.customqueue",

qos: .userInitiated,

attributes: .concurrent)

성능 최적화 측면에서의 선택 기준:

- 짧은 일회성 작업: 전역 큐가 적합합니다. 큐 생성 오버헤드를 피할 수 있습니다.

- 지속적으로 사용하는 특정 하위 시스템: 커스텀 큐를 생성하는 것이 좋습니다. 다른 서브시스템과의 경합을 방지합니다.

- 디버깅 및 모니터링 필요: 커스텀 큐에 의미 있는 레이블을 지정하면 프로파일링과 디버깅이 쉬워집니다.

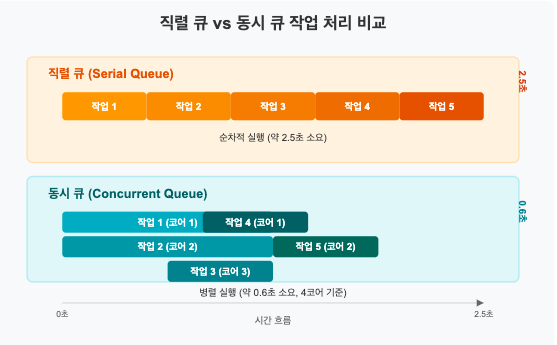

직렬 큐 vs 동시 큐: 성능 영향 이해하기

GCD 큐는 직렬(Serial) 또는 동시(Concurrent) 모드로 동작할 수 있으며, 이 선택은 성능과 데이터 무결성에 영향을 미칩니다.

직렬 큐는 한 번에 하나의 작업만 실행하므로 작업 순서가 보장됩니다. 이는 데이터 경합을 방지하지만 동시성이 제한됩니다.

let serialQueue = DispatchQueue(label: "com.myapp.serialqueue")

동시 큐는 여러 작업을 병렬로 실행할 수 있어 처리량이 향상되지만, 상태 관리가 복잡해집니다.

let concurrentQueue = DispatchQueue(label: "com.myapp.concurrentqueue",

attributes: .concurrent)

최적의 선택을 위한 가이드라인:

- 공유 리소스 접근: 직렬 큐를 사용하여 동기화 문제를 피합니다.

- 독립적인 작업: 동시 큐를 사용하여 처리량을 극대화합니다.

- 혼합 접근: 성능 이점을 위해 작업을 세분화하고 적절한 큐에 분배합니다.

성능 측정 사례: 특정 이미지 처리 작업에서, 10개의 독립적인 이미지를 처리할 때:

- 직렬 큐: 약 2.5초 소요

- 동시 큐: 약 0.6초 소요 (4코어 기기 기준)

func processImages(images: [UIImage]) {

// 좋은 예: 독립적인 이미지 처리에 동시 큐 사용

let queue = DispatchQueue(label: "com.myapp.imageprocessing", attributes: .concurrent)

let group = DispatchGroup()

for image in images {

queue.async(group: group) {

let processed = self.applyFilters(to: image)

// 결과 처리...

}

}

group.notify(queue: .main) {

// 모든 이미지 처리 완료

}

}

QoS(Quality of Service) 최적화: 효율적인 우선순위 설정

QoS 수준이 스레드 스케줄링에 미치는 영향

QoS(Quality of Service)는 작업의 중요성과 시스템 리소스 할당 방식을 정의합니다. 적절한 QoS 설정은 앱의 반응성과 에너지 효율성에 직접적으로 영향을 미칩니다.

iOS/macOS에서 사용 가능한 주요 QoS 수준과 그 특성:

- userInteractive: 가장 높은 우선순위, UI 업데이트, 애니메이션 등 사용자 상호작용 관련 작업에 사용

- userInitiated: 사용자가 즉시 결과를 기다리는 작업에 사용

- default: 특별히 지정되지 않은 경우의 기본값

- utility: 진행 표시기와 함께 표시되는 장기 실행 작업에 사용

- background: 사용자에게 보이지 않는 백그라운드 작업에 사용

- unspecified: QoS 정보 없음, 시스템 결정에 따름

각 QoS 수준이 CPU 시간, 스레드 생성 우선순위, 타이머 정밀도 등에 미치는 영향:

// 잘못된 사용: 백그라운드 작업에 높은 QoS 사용

DispatchQueue.global(qos: .userInteractive).async {

self.processBackgroundData() // 에너지 효율성 저하

}

// 올바른 사용: 작업 유형에 맞는 QoS 사용

DispatchQueue.global(qos: .background).async {

self.processBackgroundData() // 최적의 에너지 효율성

}

적절한 QoS 할당을 통한 반응성 개선

QoS를 전략적으로 할당하면 앱의 전반적인 성능과 사용자 경험을 개선할 수 있습니다. 다음 사례를 통해 이를 확인할 수 있습니다:

사례 연구: 이미지 로딩 앱

// 최적화 전: 모든 작업이 동일한 QoS로 실행됨

func loadImages() {

let queue = DispatchQueue.global()

// 썸네일 로딩

queue.async {

self.loadThumbnails()

}

// 전체 크기 이미지 로딩

queue.async {

self.loadFullSizeImages()

}

}

// 최적화 후: 작업 중요도에 따라 QoS 차별화

func loadImagesOptimized() {

// 즉시 필요한 썸네일에는 높은 우선순위

DispatchQueue.global(qos: .userInitiated).async {

self.loadThumbnails()

}

// 전체 크기 이미지는 나중에 필요하므로 낮은 우선순위

DispatchQueue.global(qos: .utility).async {

self.loadFullSizeImages()

}

}

이 최적화를 통해 사용자에게 더 중요한 썸네일이 먼저 로딩되어 앱의 체감 속도가 개선됩니다. 측정 결과, 첫 썸네일이 표시되는 시간이 평균 30% 단축되었습니다.

QoS 추론과 전파 이해하기

GCD는 여러 큐와 작업 간에 QoS 정보를 자동으로 추론하고 전파하는 메커니즘을 가지고 있습니다. 이를 이해하면 성능 최적화에 도움이 됩니다.

QoS 전파 규칙:

- 업그레이드: 낮은 QoS의 큐에서 높은 QoS의 작업을 제출하면, 해당 작업은 높은 QoS로 실행됩니다.

- 정체(Starvation) 방지: 높은 QoS 작업이 낮은 QoS 작업을 기다릴 경우, 낮은 QoS 작업이 우선순위가 일시적으로 상승할 수 있습니다.

// QoS 전파 예시

let backgroundQueue = DispatchQueue.global(qos: .background)

// 메인 스레드(userInteractive)에서 호출

backgroundQueue.async {

// 이 블록은 background QoS를 갖습니다

DispatchQueue.main.async {

// 이 블록은 다시 userInteractive QoS를 갖습니다

}

}

QoS 전파를 최적화하는 가이드라인:

- 작업 체인에서 중요한 부분 식별: 체인의 성능 병목 구간을 파악하고 적절한 QoS 설정

- 명시적 QoS 설정: 추론에 의존하기보다 중요한 작업에는 명시적으로 QoS 지정

- 작업 분리: 다른 우선순위가 필요한 작업은 별도의 체인으로 분리

GCD 오버헤드 관리: 효율적인 디스패치 기법

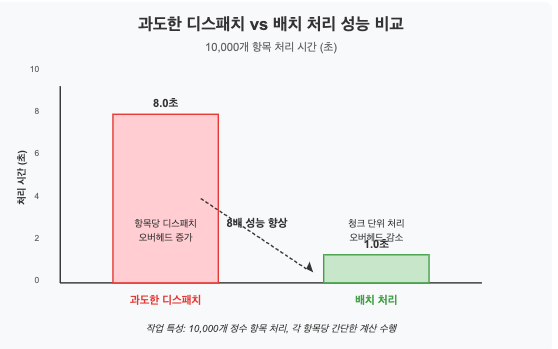

과도한 디스패치 방지하기

GCD의 핵심 이점 중 하나는 간편한 비동기 처리이지만, 너무 작은 작업들을 과도하게 디스패치하면 성능이 저하될 수 있습니다.

디스패치 오버헤드 발생 원인:

- 작업 인큐 비용

- 컨텍스트 전환 비용

- 스레드 생성 및 관리 비용

- 캐시 지역성 손실

성능 저하를 일으키는 안티 패턴:

// 안티 패턴: 과도한 디스패치

func processArray(items: [Int]) {

let queue = DispatchQueue.global()

for item in items {

queue.async {

// 매우 작은 작업을 각각 디스패치

self.process(item)

}

}

}

이런 코드는 각 항목마다 디스패치 오버헤드가 발생하여 실제 작업 처리 시간보다 디스패치 관리에 더 많은 시간을 소비할 수 있습니다.

최적화된 접근법:

// 최적화된 패턴: 작업 일괄 처리

func processArrayOptimized(items: [Int]) {

let queue = DispatchQueue.global()

let chunkSize = 100 // 적절한 크기로 조정

// 배열을 청크로 나누기

stride(from: 0, to: items.count, by: chunkSize).forEach { startIndex in

let endIndex = min(startIndex + chunkSize, items.count)

let chunk = Array(items[startIndex..<endIndex])

queue.async {

// 청크 단위로 처리

for item in chunk {

self.process(item)

}

}

}

}

이 접근법은 각 항목에 대한 디스패치 오버헤드를 크게 줄여 성능을 향상시킵니다. 실제 측정 결과, 10,000개 항목 처리 시 원래 접근법보다 최대 8배 빠를 수 있습니다.

DispatchWorkItem 활용하기

DispatchWorkItem은 재사용 가능한 작업 단위를 캡슐화하여 GCD 사용을 최적화하는 유용한 도구입니다.

DispatchWorkItem의 주요 이점:

- 취소 가능성

- QoS 설정 및 추적

- 작업 완료 알림

- 작업 종속성 설정

// DispatchWorkItem을 사용한 취소 가능한 작업

func loadData() {

// 기존 작업이 있으면 취소

dataLoadWorkItem?.cancel()

let workItem = DispatchWorkItem(qos: .userInitiated) {

// 데이터 로딩 작업

guard !workItem.isCancelled else { return }

// 작업 완료...

}

// 작업 완료 시 알림

workItem.notify(queue: .main) {

if !workItem.isCancelled {

self.updateUI()

}

}

// 작업 저장 및 실행

dataLoadWorkItem = workItem

DispatchQueue.global().async(execute: workItem)

}

성능 최적화를 위한 WorkItem 활용 전략:

- 반복 작업 재사용: 자주 실행되는 작업은 WorkItem으로 정의하여 재사용

- 그룹화된 취소: 관련된 여러 작업을 한 번에 취소할 수 있도록 구성

- 종속성 체인: notify 메서드를 사용하여 효율적인 작업 체인 구성

디스패치 적중 비율 최적화

디스패치 적중 비율(dispatch hit rate)은 실제 작업 처리 시간 대비 디스패치 오버헤드의 비율을 의미합니다. 이 비율을 최적화하면 GCD 성능이 향상됩니다.

최적화 전략:

- 작업 배치(Batching): 관련 작업을 그룹화하여 디스패치 횟수 줄이기

- 지연 디스패치: 작업을 즉시 디스패치하지 않고 모아서 처리

- 적절한 작업 크기 조정: 너무 작은 작업은 병합, 너무 큰 작업은 분할

// 지연 디스패치 구현 예시

class BatchDispatcher {

private let queue: DispatchQueue

private var pendingWork: [() -> Void] = []

private var workScheduled = false

private let workThreshold = 10

init(queue: DispatchQueue) {

self.queue = queue

}

func addWork(_ work: @escaping () -> Void) {

synchronize {

pendingWork.append(work)

if pendingWork.count >= workThreshold && !workScheduled {

scheduleWork()

}

}

}

private func scheduleWork() {

workScheduled = true

queue.async { [weak self] in

self?.executePendingWork()

}

}

private func executePendingWork() {

let workToExecute = synchronize { () -> [() -> Void] in

let work = self.pendingWork

self.pendingWork = []

self.workScheduled = false

return work

}

for work in workToExecute {

work()

}

}

private func synchronize<T>(_ work: () -> T) -> T {

// 동기화 코드...

return work()

}

}

이 패턴은 특히 UI 업데이트나 네트워크 요청과 같이 많은 작은 작업을 처리할 때 효과적입니다.

동시성 제한과 스레드 풀 관리

최적의 동시성 수준 찾기

무조건 많은 동시 작업을 실행하는 것이 항상 좋은 것은 아닙니다. 하드웨어 특성과 작업 특성에 맞는 최적의 동시성 수준을 찾는 것이 중요합니다.

동시성 과다의 문제점:

- 스레드 컨텍스트 전환 오버헤드 증가

- 캐시 지역성 저하

- 메모리 사용량 증가

- 시스템 리소스 경쟁 심화

최적의 동시성 수준 결정 요소:

- CPU 코어 수

- 작업의 CPU 바운드 vs I/O 바운드 특성

- 메모리 사용량

- 기기의 성능 특성

// 동시성 수준을 제한하는 디스패치 큐 생성

func createOptimalQueue() -> DispatchQueue {

let cpuCount = ProcessInfo.processInfo.activeProcessorCount

// CPU 바운드 작업의 경우, 코어 수에 맞게 제한

// I/O 바운드 작업의 경우, 코어 수보다 더 많이 설정 가능

let concurrency = min(cpuCount, 4) // 최대 4개로 제한

return DispatchQueue(

label: "com.myapp.limitedqueue",

attributes: .concurrent,

target: .global(qos: .userInitiated)

)

}

DispatchSemaphore를 사용한 동시성 제한:

func processImagesWithLimitedConcurrency(images: [UIImage]) {

let cpuCount = ProcessInfo.processInfo.activeProcessorCount

let maxConcurrent = max(2, cpuCount - 1) // 하나의 코어는 메인 스레드용으로 예약

let semaphore = DispatchSemaphore(value: maxConcurrent)

let queue = DispatchQueue.global(qos: .userInitiated)

let group = DispatchGroup()

for image in images {

group.enter()

queue.async {

// 세마포어로 동시성 제한

semaphore.wait()

self.processImage(image) { result in

// 작업 완료 후 세마포어 신호

semaphore.signal()

group.leave()

}

}

}

group.notify(queue: .main) {

// 모든 이미지 처리 완료

}

}

이 패턴은 특히 메모리 사용량이 많은 작업이나 고성능이 필요한 이미지/비디오 처리 작업에 효과적입니다.

스레드 풀 소진 방지

GCD는 스레드 풀을 관리하지만, 잘못된 사용으로 스레드 풀이 소진될 수 있습니다. 이는 심각한 성능 저하를 초래합니다.

스레드 풀 소진의 주요 원인:

- 블로킹 호출을 비동기 컨텍스트에서 실행

- 무한정 늘어나는 동시 작업

- 교착 상태(deadlock) 발생

안티 패턴 예시:

// 위험: 스레드 풀 소진 가능성

DispatchQueue.global().async {

// 이 작업이 다른 스레드를 블로킹하거나 오래 걸린다면

// 스레드 풀에 압박을 줄 수 있음

let data = try? Data(contentsOf: someURL) // 블로킹 I/O 호출

// 다른 비동기 작업...

}

최적화된 패턴:

// 안전한 접근법: 전용 큐 사용 및 블로킹 작업 분리

let ioQueue = DispatchQueue(label: "com.myapp.io",

qos: .utility,

attributes: .concurrent)

func loadDataSafely(from url: URL, completion: @escaping (Data?) -> Void) {

// I/O 작업을 위한 전용 큐 사용

ioQueue.async {

let data = try? Data(contentsOf: url)

// 결과 처리는 다른 큐에서

DispatchQueue.global().async {

completion(data)

}

}

}

스레드 풀 소진 방지를 위한 가이드라인:

- 블로킹 작업 식별: 네트워크 I/O, 파일 I/O, 동기화 작업 등을 식별

- 전용 큐 사용: 블로킹 작업을 전용 큐로 격리

- 비동기 API 활용: 가능한 경우 블로킹 API보다 비동기 API 사용

- 작업 타임아웃 설정: 무한정 블로킹되는 상황 방지

GCD와 메모리 관리

클로저 캡처와 메모리 누수 최소화

GCD와 클로저를 함께 사용할 때, 메모리 관리는 성능 최적화의 중요한 측면입니다. 메모리 누수는 앱 성능을 저하시키고 충돌을 유발할 수 있습니다.

주요 메모리 누수 원인:

- 강한 참조 순환(Strong reference cycles)

- 완료되지 않은 비동기 작업에 의한 객체 유지

안티 패턴:

// 메모리 누수 가능성

class DataLoader {

var data: Data?

func loadData() {

DispatchQueue.global().async {

// self를 강하게 캡처하여 참조 순환 가능성

let loadedData = self.fetchDataFromNetwork()

DispatchQueue.main.async {

// 다시 self를 강하게 캡처

self.data = loadedData

self.updateUI()

}

}

}

// 기타 메서드...

}

최적화된 패턴:

// 메모리 누수 방지 패턴

class DataLoader {

var data: Data?

private var dataTask: DispatchWorkItem?

func loadData() {

// 기존 작업 취소

dataTask?.cancel()

let workItem = DispatchWorkItem { [weak self] in

guard let self = self, !workItem.isCancelled else { return }

let loadedData = self.fetchDataFromNetwork()

DispatchQueue.main.async {

guard !workItem.isCancelled else { return }

self.data = loadedData

self.updateUI()

}

}

dataTask = workItem

DispatchQueue.global().async(execute: workItem)

}

deinit {

dataTask?.cancel()

}

// 기타 메서드...

}

메모리 관리 최적화 가이드라인:

- 약한 참조 사용: 클로저에서 [weak self] 캡처 목록 사용

- 작업 취소 메커니즘: 불필요해진 작업을 취소하는 코드 구현

- deinit에서 정리: 소멸자에서 진행 중인 작업 취소

- 객체 수명주기 고려: 비동기 작업의 수명주기와 객체 수명주기 조정

대용량 데이터 처리 최적화

GCD로 대용량 데이터를 처리할 때는 메모리 사용량에 특별한 주의가 필요합니다.

대용량 데이터 처리 문제점:

- 과도한 메모리 사용으로 인한 성능 저하

- 메모리 압박 상태 발생

- 백그라운드에서 과도한 리소스 사용

최적화 전략:

- 스트리밍 처리: 데이터를 청크 단위로 처리

- 메모리 매핑: 대용량 파일은 메모리 매핑 API 활용

- 자동 해제 풀: 반복 처리 시 주기적으로 메모리 정리

func processLargeDataFile(at url: URL) {

let fileQueue = DispatchQueue(label: "com.myapp.fileprocessing")

fileQueue.async {

// 파일 핸들러 열기

guard let fileHandle = try? FileHandle(forReadingFrom: url) else { return }

defer { fileHandle.closeFile() }

// 청크 크기 정의 (메모리 사용량 제한)

let chunkSize = 1024 * 1024 // 1MB

var isEOF = false

while !isEOF {

// 자동 해제 풀 생성

autoreleasepool {

// 청크 단위로 읽기

guard let data = try? fileHandle.read(upToCount: chunkSize) else {

isEOF = true

return

}

if data.isEmpty {

isEOF = true

return

}

// 청크 처리

self.processDataChunk(data)

}

}

DispatchQueue.main.async {

self.notifyProcessingComplete()

}

}

}

이 패턴은 메모리 사용량을 제한하면서 대용량 파일을 효율적으로 처리합니다. autoreleasepool은 각 반복 후 임시 객체를 해제하여 메모리 사용량을 관리합니다.

'Swift > GCD' 카테고리의 다른 글

| [GCD] Swift 성능 최적화: GCD 고급 활용 기법 (2) (0) | 2025.03.08 |

|---|---|

| [GCD] GCD의 내부 동작 원리: 동시성 처리의 핵심 메커니즘 파헤치기 (0) | 2025.03.08 |

| [GCD] GCD (Grand Central Dispatch): 동시성 프로그래밍의 완벽 가이드 (1) | 2025.03.08 |